Xの「おすすめ」がユーザーの政治的意見を変える(不可逆に)

Xの「おすすめ」フィードを使っていると、自分がフォローしていないアカウントの投稿が流れてくる。内容を目にし、反応やフォローをする。それがいつの間にか「自分のタイムライン」になっている。

この感覚に、因果的なエビデンスがついた。

2026年2月18日、Natureにある論文が掲載された[1]。ボッコーニ大学のジェルマン・ゴーティエ、ザンクトガレン大学のローランド・ホドラー、パリ経済学院のフィリーヌ・ヴィドマーとエカテリーナ・ジュラフスカヤ。4人の研究者が、4,965人の米国Xユーザーを対象に無作為に振り分けた実験を実施した。約7週間、一方のグループにはアルゴリズム型の「おすすめ(For You)」フィードを、もう一方には時系列型の「フォロー中(Following)」フィードを使わせた。

「おすすめ」を使うと、政治的意見がより保守的な方向(more conservative positions)にシフトした。設定を「フォロー中」に戻しても、意見は元に戻らなかった。

アルゴリズムがフィードに何をしているか

まず前提を整理する。

Xの「おすすめ」フィードが表示するコンテンツの約半分は、ユーザーがフォローしていないアカウントの投稿だ[2]。機械学習がエンゲージメント(いいね、リポスト、返信など)の予測確率でランク付けし、スコアの高い投稿を上位に表示する。「フォロー中」フィードは単純。自分がフォローしているアカウントの投稿が、新しい順に並ぶだけだ。

実験前、参加者の76%がデフォルトの「おすすめ」フィードを使っていた。

重要なのは、この実験がXとは完全に独立して行われたこと。スイス国立科学基金の資金提供で、Xとの協力もデータ共有もない。後述するが、2023年のMeta出資による類似研究は、まさにこの独立性の欠如が問題になった。

報道機関アカウントの表示が58.1%消える

実験では、参加者の一部(599人)にインストールしたChrome拡張機能で、フィードに実際に表示されたコンテンツを分析している。

「おすすめ」フィードでは、右寄りのコンテンツ(right-leaning content)が「フォロー中」フィードと比較して19.9%多く表示された。左寄りのコンテンツ(left-leaning content)は3.1%の微増にとどまる。

だが最も劇的な変化はそこではない。「おすすめ」では、既存の報道機関アカウントからの投稿が58.1%減った。左寄りも右寄りも関係なく、報道機関が丸ごと格下げされた。代わりに増えたのは、政治活動家アカウント(27.4%増)とエンターテインメント(21.5%増)。

報道機関が消え、政治活動家が増える。

共著者のホドラーはこう述べている。「アルゴリズムが、質の高いジャーナリズムではなく、政治活動家による単純化された、しばしば対立を煽るような発言(polarizing statements)を増幅していることに衝撃を受けた」[3]。アルゴリズムが表示する投稿は、時系列フィードと比べて、いいねが平均約4.8倍、リポストが約4倍、コメントが約5倍だった。

ウクライナへの見方が変わる

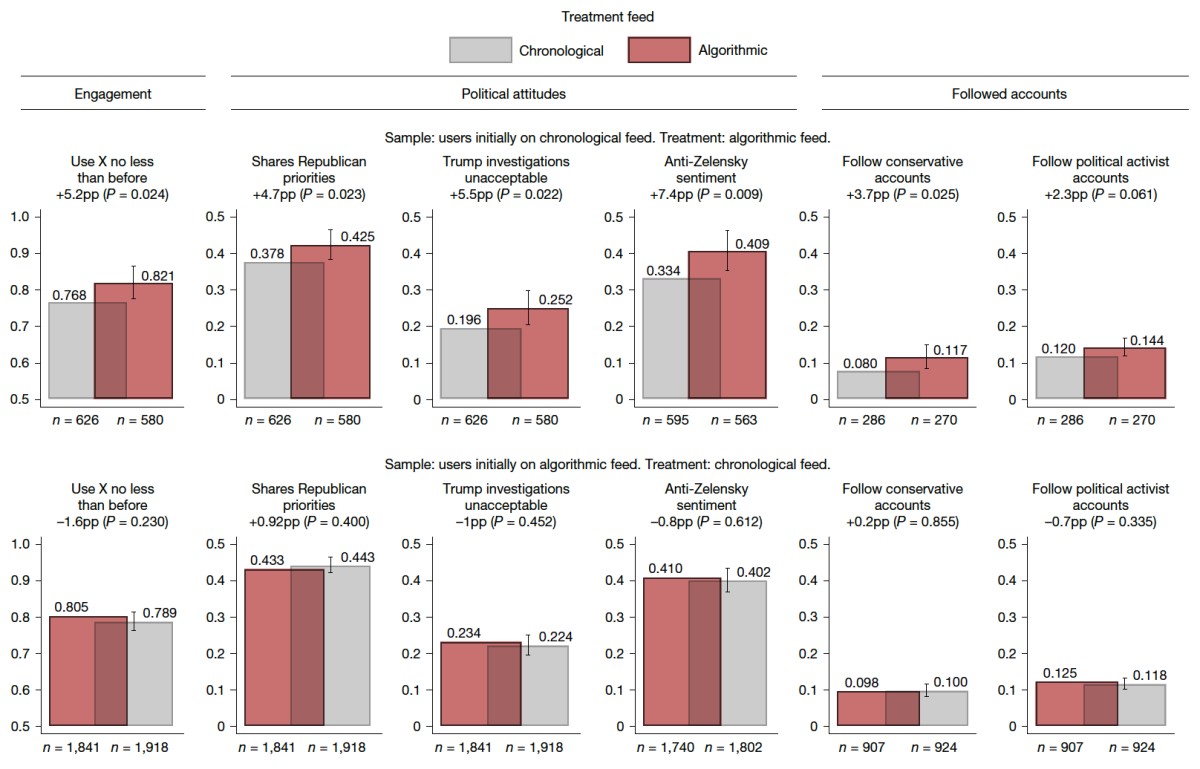

「フォロー中」フィードから「おすすめ」に切り替えられたユーザーの間で、以下が観察された。共和党寄りの政策課題(犯罪、インフレ、移民)を優先する確率が+4.7ポイント。トランプに対する刑事捜査を「容認できない」と考える確率が+5.5ポイント。ゼレンスキーに対する肯定的な見方が−7.4ポイント。ロシア・ウクライナ戦争に関するクレムリン寄りの態度が+0.12標準偏差(複数の質問を組み合わせた指標のため、効果量は標準偏差で報告されている)[4]。

全体として、政策態度指標はより保守的な方向(more conservative)に0.12標準偏差シフトした(P = 0.004)。効果は共和党支持者と無党派層に集中し、民主党支持者にはほぼ影響がなかった。

7週間でゼレンスキーへの評価が7.4ポイント動く。フィードを切り替えただけで。

興味深いのは、アルゴリズムが変えなかったものだ。自己報告による党派性(「自分は共和党寄りだ」「民主党寄りだ」という認識)、感情的分極化(affective polarization)、生活満足度——これらには有意な変化がなかった。感情的分極化とは、政策の賛否とは別に、政党やその支持者に対して抱く嫌悪や不信の度合いを指す。「あの党の政策は間違っている」ではなく「あの党の人間が嫌いだ」の強度。これが動かなかったということは、アルゴリズムは「何が重要か」の認識を変えたが、「誰が敵か」の感情までは変えなかったことになる。

著者らは以下のように述べている。

目の前の争点に関する意見は変わりやすく、深い政治的アイデンティティよりも速く動く。後者が動くには、数週間の実験よりはるかに長い時間が必要かもしれない

opinions on current issues may be more malleable and shift more quickly than deeper political identities, which may require much longer to shift than an experiment lasting several weeks.

表層は動く。深層はまだ動かない——7週間では。

「フォロー中」に戻しても意見は元に戻らない

この論文で最も重大な発見はここだ。

「おすすめ」を使うと、意見が変化した。では「フォロー中」に戻したら? 検出可能な効果はゼロだった。「おすすめ」から「フォロー中」に戻したユーザーの政治的意見は、ベースラインに回帰しなかった。すべての指標で有意な変化は見つからなかった[6]。

なぜか。

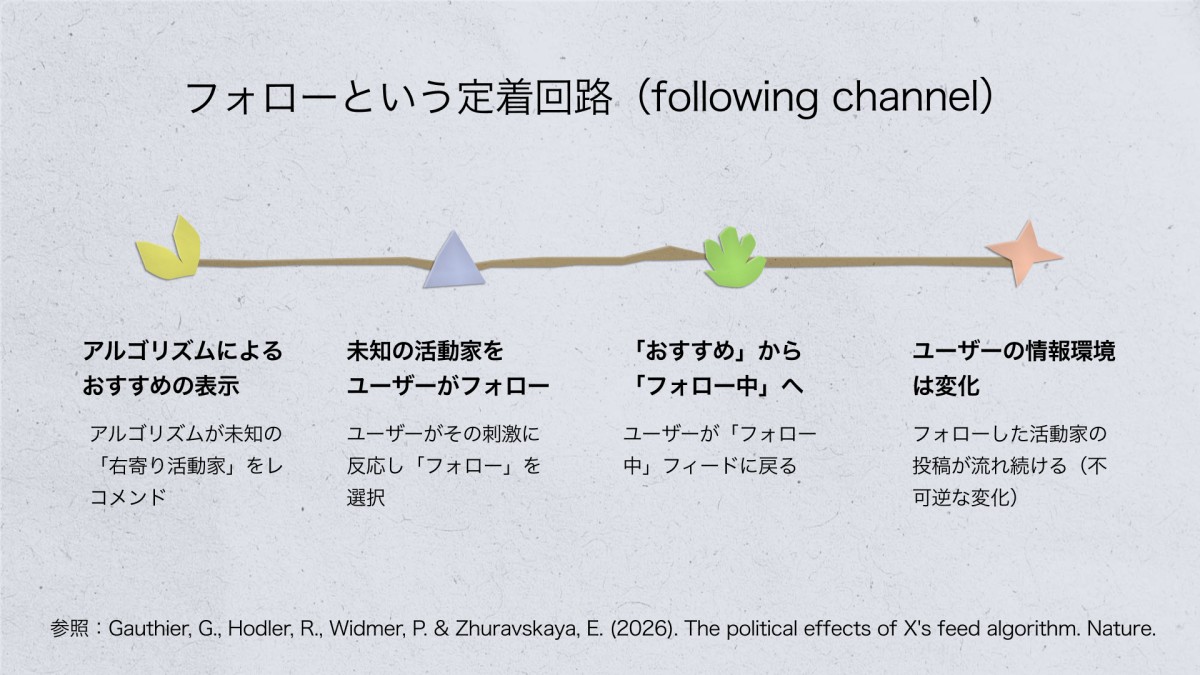

「おすすめ」フィードに晒されたユーザーは、自分からは見つけなかったであろう右寄りの政治活動家アカウントに出会い、フォローした。フォローはアルゴリズムと無関係に持続する行動だ。「フォロー中」フィードに戻しても、新たにフォローしたアカウントの投稿がタイムラインに表示される。以前「おすすめ」を使っていたユーザーの「フォロー中」フィードには、ずっと「フォロー中」を使っていたユーザーと比べて、右寄りアカウント(right-leaning accounts)の投稿が60%多く、右寄りの政治活動家(right-leaning activist)の投稿が28%多く含まれていた[7]。

著者らはこれを「フォローという定着回路(following channel)」と呼ぶ。アルゴリズムがレコメンドし、ユーザーがフォローする。フォローリストは「おすすめ」を切っても残る。

Metaの「無罪証明」が崩れる

先行研究では「フィードを変えても政治的意見は変わらなかった」という結果が出ている。2023年、MetaがScience誌に発表した大規模実験だ[8]。約20,000人のFacebook・Instagramユーザーを対象に、アルゴリズム型フィードと時系列フィードを比較した。結論は「有意な効果なし」。Metaはこの結果を「自社プラットフォームは感情的分極化を引き起こさない」エビデンスとして引用した。

ゴーティエらの論文は、この結果との矛盾を次のように説明している。ゴーティエの実験では、普段「フォロー中」を使っていた人が「おすすめ」に切り替わるケースと、普段「おすすめ」を使っていた人が「フォロー中」に切り替わるケースの両方が生じた。政治的意見のシフトが見つかったのは前者(「おすすめ」に切り替えた方向)だけだ。「おすすめ」から「フォロー中」に切り替えた方向では、有意な効果が出なかった。不可逆性を考えれば当然だ。Meta研究は後者の方向しかテストしていない。発見が出る方向を、そもそも実験していなかった。

ここからはゴーティエ論文の外側の話になる。

Meta研究自体の独立性にも疑義がある。2024年にScience誌に掲載されたBagchiらの批判論文によると、Meta研究はMetaとの提携で実施され、Meta従業員が共著者でデータアクセスを管理していた。さらに研究期間中(2020年米大統領選前後)にMetaは誤情報の拡散を抑えるためにアルゴリズムへの緊急介入を63回行っていた——特定コンテンツの拡散速度を落とす、信頼性の低いソースの表示を減らすなどの手動調整だ[9]。つまりテストされた「通常のアルゴリズム」は、すでに手が加えられた後の状態だった。

そしてイーロン・マスク体制下のXは、Metaとはそもそも根本的に異なる政治経済で動いている。マスク個人の投稿への1,000倍ブースト[10]。Substack、Bluesky、NYT、Reutersへのリンク表示抑制。2025年後半のGrok AI搭載レコメンドシステムへの移行。一人の人間の政治的選好が、アーキテクチャとしてエンコードされている。

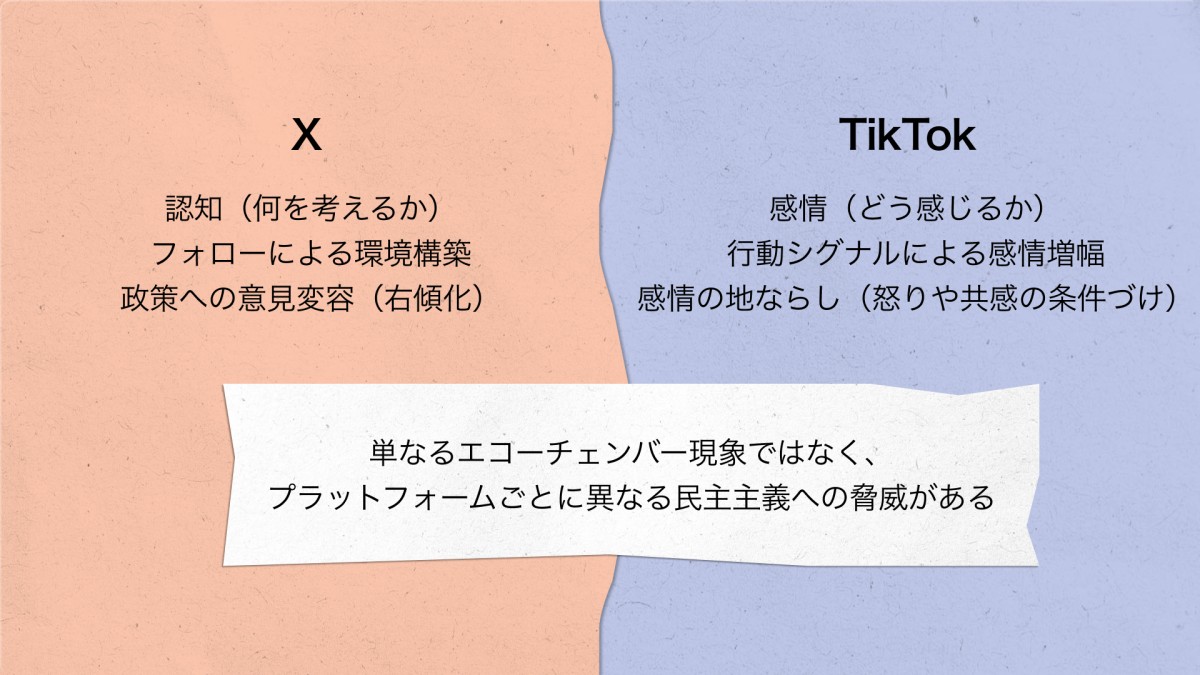

TikTokは何を考えるかではなく、どう感じるかを条件づける

Xのアルゴリズムが認知レベルで政治的意見を変えることを示した論文と、対になる研究がある。

米国の安全保障誌『War on the Rocks』に、マイケル・モーガンが2026年1月に発表した論考「TikTok、アルゴリズムによる感情操作、そして新たなプロパガンダの戦場(TikTok, Algorithmic Emotion, and the New Propaganda Battlefield)」[11]。193人の大学生のTikTokユーザーを対象に、ガザにおけるイスラエルの軍事作戦の期間中、紛争関連コンテンツへの感情的反応を調べた。

コアとなる発見はこれだ。TikTokはユーザーに何を考えるかを指示しない。どう感じるかを条件づける。

イデオロギー的な自己認識(「自分は左寄りだ」「右寄りだ」)は、プラットフォーム使用にかかわらず安定していた。変わったのは感情の強度だ。共感、怒り、悲嘆、憤り。TikTokを信頼できると認識していた参加者は、政治的立場の変化を伴わずに、有意に強い感情的反応を示した[12]。

メカニズムは意図的ではない。TikTokのレコメンドシステムは、リプレイ、一時停止、スクロール速度といった行動に関するマイクロシグナルを追跡し、強化ループを形成する。感情的な反応がコンテンツ選択を駆動し、選択されたコンテンツがさらなる感情的な反応を駆動する。繰り返しのサイクルを経て、フィードは「感情的に均質」になる。

モーガンはこれを「感情的な地ならし(emotional pre-alignment)」と名づけた。イデオロギー的コミットメントに先行し、かつそれとは独立して生じる、感情的な変容[13]。道徳的共感や怒りの帰属は、イデオロギー的な立場が固まる前に条件づけられている。

古典的な「エコーチェンバー」とは違う。エコーチェンバーは、ユーザーが自分の信条に合うコンテンツを能動的に選ぶことで生まれる。感情的な地ならしは、アルゴリズム最適化を通じて受動的に出現する。ユーザーが何かを選ぶ前に、感情の地形がすでに整地されている。

Xは認知を、TikTokは感情を。層は違うが、構造は同じだ。エンゲージメント最大化という目的関数が、政治的帰結を副産物として生み出す。

人工物に政治はあるか

アメリカの技術哲学者ラングドン・ウィナーは1980年に「人工物に政治はあるか?(Do Artifacts Have Politics?)」と問うた[14]。ウィナーは、テクノロジーが二つの仕方で政治的でありうると論じた。第一に、偶発的に。設計上の選択が、結果として社会的な事柄を決着させる。第二に、本質的に。ある技術が、特定の政治的取り決めを構造的に要求する。

Xの「おすすめ」フィードはどちらか。

エンゲージメントを最大化するためのアーキテクチャは、「対立を煽るコンテンツの方が反応を集める」という人間の認知にかかわる傾向と結合して、右寄りの政治活動家を増幅し、報道機関を格下げする。これは偶発的な政治だ。Xが共和党を支援するために設計されたわけではない(少なくとも初期の設計では)。

しかし不可逆性のメカニズムは、偶発的では済まない。アルゴリズムがレコメンドし、ユーザーがフォローし、フォローはフィードの設定を変えても残る。フォローという定着回路を通じたソーシャルグラフの書き換えは、エンゲージメント最大化というアーキテクチャに構造的に内在する帰結だ。ウィナーの第二の意味——ある技術が特定の政治的取り決めを構造的に要求する——に該当する。コンテンツの偏りは偶発的、ソーシャルグラフの書き換えは本質的。ゴーティエの論文の最大の貢献は、後者を実証したことにある。

マイクロソフトリサーチの研究者ケイト・クロフォードは2016年の論文「アルゴリズムは闘争的でありうるか?(Can an Algorithm be Agonistic?)」で、ベルギーの政治学者シャンタル・ムフの闘争的多元主義をアルゴリズムに適用した[15]。ムフの議論では、民主主義の本質は合意ではなく制度化された対立だ。クロフォードは、アルゴリズムが「情報の競争から明確な『勝者』を生み出すよう設計されている」と指摘した。闘争的多元主義の対極にある設計だ。

ゴーティエの数字は、クロフォードの懸念を裏付ける。報道機関の格下げ(−58%)と政治活動家の増幅(+27%)。多元的な情報環境が、エンゲージメントの最大化のために最適化された環境に置き換えられる。

おわりに——第三次把持としてのフォローリスト

フランスの技術哲学者ベルナール・スティグレールは、人間の記憶を三つの層に分けた。いま知覚していること(一次把持)、思い出すこと(二次把持)、そして道具や文字やデータベースに外部化された記憶(第三次把持)。スティグレールの核心的な主張は、第三次把持が知覚に先行するということだ。何が目に入るかは、すでにそこにある技術的構造によって決まっている。

フォローリストは第三次把持だ。「おすすめ」が書き換えたフォローリストは、アルゴリズムを切った後も残り、以降の知覚——何が見え、何が見えないか——を構成し続ける。スティグレールはこの過程を「プロレタリア化」と呼んだ。自分の情報環境を自分で構成する能力が、プラットフォームに移転される過程だ。

「『おすすめ』をやめて『フォロー中』に切り替えればいい」「リテラシーを高めればいい」といった解釈は、外部記憶の水準で起きている変容に対して、個人の意志で対処しようとする試みだ。しかし問題は異なる層で起きている。

ニュースレター、登録は無料です。よろしければ。

脚注

[1]Gauthier, G., Hodler, R., Widmer, P. & Zhuravskaya, E. (2026). The political effects of X's feed algorithm. Nature. https://doi.org/10.1038/s41586-026-10098-2

[2]X Engineering, "Twitter's Recommendation Algorithm," March 31, 2023. https://blog.x.com/engineering/en_us/topics/open-source/2023/twitter-recommendation-algorithm 原文:"the For You timeline consists of 50% In-Network Tweets and 50% Out-of-Network Tweets on average, though this may vary from user to user." 本実験の実施期間(2023年7月〜9月)にはこのアルゴリズムが適用されていた。2026年1月にGrokベースの新アーキテクチャ(Phoenix)が公開されたが、本実験には適用されない。

[3]Gauthier et al. (2026) のプレスリリースより。原文:"It was shocking to see how the algorithm promotes simplistic and often polarizing statements by political activists rather than high-quality journalism."

[4]Gauthier et al. (2026), Table 2 and Extended Data Table 3.

[5]Gauthier et al. (2026), Discussion. 原文:"opinions on current issues may be more malleable and shift more quickly than deeper political identities, which may require much longer to shift than an experiment lasting several weeks."

[6]Gauthier et al. (2026), Table 3, Panel B.

[7]Gauthier et al. (2026), Figure 4 and Extended Data Table 5.

[8]Guess, A. M. et al. (2023). How do social media feed algorithms affect attitudes and behavior in an election campaign? Science, 381(6656), 398–404. https://doi.org/10.1126/science.abp9364

[9]Bagchi, A. et al. (2024). Comment on Guess et al. (2023). Science. Meta研究期間中にMetaが63の「ブレークグラス」緊急措置を実施していたことを指摘。

[10]2023年2月のスーパーボウル期間中にマスクの投稿が通常の1,000倍のブーストを受けていたことが内部報告で判明。Zoë Schiffer and Casey Newton, "Yes, Elon Musk created a special system for showing you all his tweets first," Platformer, February 14, 2023. https://www.platformer.news/elon-musk-twitter-algorithm-for-you/

[11]Michael Morgan, "TikTok, Algorithmic Emotion, and the New Propaganda Battlefield," War on the Rocks, January 27, 2026. https://warontherocks.com/2026/01/tiktok-algorithmic-emotion-and-the-new-propaganda-battlefield/

[12]Morgan (2026). 参加者は18〜30歳、ミシガン州の4大学から募集、全員がTikTokを主要ニュースソースとして報告。

[13]Morgan (2026). 原文:"a measurable shift in affective orientation that occurs prior to, and independently from, ideological commitment."

[14]Langdon Winner, "Do Artifacts Have Politics?," Daedalus 109, no. 1 (1980): 121–136.

[15]Kate Crawford, "Can an Algorithm be Agonistic? Ten Scenes from Life in Calculated Publics," Science, Technology, & Human Values 41, no. 1 (2016): 77–92. https://doi.org/10.1177/0162243915589635

[16]GIGAZINE「X(旧Twitter)のアルゴリズムが政治にどのような影響を与えているのか?を調べた論文が登場」2026年2月19日。Nature Asia「社会科学:Xのアルゴリズムは政治的態度に影響を与えるかもしれない」2026年2月19日。

[17]European Commission, "Commission fines X €120 million for breach of Digital Services Act," December 2025. 青いチェックマークのデザインの欺瞞性、不十分な広告リポジトリ、研究者へのデータアクセスの不提供が理由。

[18]Martin Saveski et al. (2025). The effectiveness of community notes on social media platforms. Proceedings of the National Academy of Sciences. ノートが付くとリポストが46%、いいねが44%減少するが、ノートが付くまでの中央値は18時間超、投稿されたノートの公開率は12.5%。

すでに登録済みの方は こちら