AIは誰の死を撹乱するのか?

「こんにちは。これを見ているすべての方へ、はっきりお伝えしておきます。私はクリス・ペルキーをAIで再現したバージョンです。私の写真と、私の声のプロファイルを使っています」[1]

2025年5月1日、アリゾナ州マリコパ郡上級裁判所。射殺された男がAI映像を通じて法廷に「現れ」、加害者に語りかけ、赦しの言葉を述べた。判事は「あのAIは素晴らしかった」と口にし、求刑を超える判決を下した。

この記事では三つの事例を取り上げる。死者に声を与えるAI、誰が死ぬかを決めるAI、生者を死に向かわせるLLM。それぞれを見ていくと、同じ問いにたどり着く——誰の死が「死」としてカウントされるのか。そしてその問いは、生成AIが普及する以前から存在していた諸問題を照らしだす。

法廷で「語った」死者

2021年11月、あおり運転をきっかけとした口論の末にクリストファー・ペルキー氏(当時37歳)が射殺された。

2025年5月1日、マリコパ郡上級裁判所。ペルキー氏がAI映像を通じて法廷に「現れた」[2]。映像内のペルキー氏は、自らを殺したガブリエル・ホルカシタス受刑者に向けて語りかけた。

「あの日あのような状況で出会ったのは残念だ。別の人生であれば、きっと友だちになれていたと思う。私は赦しを信じている、赦してくださる神を信じている。ずっとそうだった。今も、そう信じている」[3]

映像を作成したのは、ペルキー氏の姉ステイシー・ウェールズ氏とその夫ティム氏。テック業界で勤務しており、企業向けにAIアバターを制作した経験があった[4]。複数のソフトウェアプラットフォームを用いて、ペルキー氏の写真と動画から姿と声を再現した[5]。

姉のステイシー氏は、自分自身は加害者を赦す準備ができていなかったと語っている。しかし敬虔なクリスチャンだった弟なら赦しの言葉を述べただろうと考え、その「声」を代弁させることにした[6]。彼女はBBCに次のように語った。「(生成AIは)強力なツールだからこそ、倫理と道徳をもって取り組んだ。ハンマーだって、窓を割ることも壁を壊すこともできる。でも家を建てることもできる。私たちはそういう使い方をした」[7]

判事トッド・ラングは映像を見た後、「あのAIは素晴らしかった」と述べた[8]。家族は加害者に最高刑を求めていた。にもかかわらず、AIは赦しを語った。その点について、判事はこうコメントした。「最高刑を望んでいたにもかかわらず、あなたたちはクリスに彼自身の心から語らせた——あなたたちが見てきたとおりの心から」[9]

検察の求刑9年半を上回る10年半の刑が言い渡された[10]。弁護士ジェイソン・ラムは判決の数時間後に控訴通知を提出した。

判事には被害者側の陳述について広い裁量がある、それは確かだ。しかし控訴審は判断しなければならない——それが感情を煽るものとして行きすぎではなかったか、そして量刑を決めるにあたって判事がこの映像にどの程度依拠したのかを。

ラムは生成AIによる映像を「不誠実(inauthentic)」と呼び、ピノキオの比喩を用いた。「ジェペットがピノキオの口に言葉を詰め込むのと同じだ」[12]。ラムが指摘したのは、映像によって描写された「赦す人物」と、ペルキー氏が最後に見せた実際の行動との乖離だった。複数の証人によって語られたペルキー氏の最後の姿は、交差点で車を降り、腕を振り上げ、加害者に喧嘩を仕掛けた、というものだった[12]。

弁護側にAI映像の事前通知はなかった[13]。被害者側の権利擁護弁護士ジェシカ・ガットゥーゾも前夜に初めて映像を目にし、当初は躊躇したという。だがアリゾナ州法は被害者影響陳述のデジタル形式を認めており、「判事の前で、陪審員の前ではないため、法的・倫理的に大きな問題はない」と判断した[14]。

この区別は重要だ。デューク大学ロースクールのポール・グリム教授(元メリーランド州連邦地裁判事)は、AI陳述が陪審裁判ではなく量刑審理——判事のみが判断する場——で使われたことが法的なポイントだと指摘する。陪審員に見せるものには厳格な証拠規則が適用されるが、量刑審理では判事は被害者の人となりを理解するために、より広範な情報の提示を認める裁量がある。

グリムは「今後、判事は事前通知を求めるようになるだろう」と予測している[15]。アリゾナ州立大学のゲイリー・マーチャント教授(アリゾナ最高裁AI委員会メンバー)は、このケースを「死者の声を再現するAI利用としては最も異論の少ない使い方」と評価しつつ、「ディープフェイク証拠が今後増加するのは確実だ」と警告した[16]。

なお、アリゾナ州における過失致死の量刑ガイドラインは7〜21年であり、10年半は法定上限ではない。ホルカシタス受刑者は過失致死と危険行為の二罪で有罪となっており、検察は二つの刑を順に執行する連続刑を求めたが、判事は同時に執行する同時刑とした。弁護側は、トータルの実刑期間はむしろ短くなったと主張している[17]。

これは、米国の法廷でAI生成の被害者影響陳述が使用された最初の事例とされる[18]。控訴は2025年5月に提出され、2026年2月時点で判断は出ていない。

ペルキー事件は孤立したエピソードではない。同じ月、ニューヨークでは原告がAIアバターに法廷弁論をさせようとして控訴審判事に即座に却下された。連邦司法パネルはAI生成証拠に人間の専門家証人と同等の信頼性基準を求めるドラフト規則を推進中だ[19]。

死者が「語る」とき、その言葉は誰のものなのか。遺族の解釈を通じて再構成された死者の「意志」は、どこまで本人のものといえるのか。

デジタル・アフターライフ産業(DAI)——「私の車」と「私の手」

死者のデータからプロダクトやサービスを作り出す産業が、すでに動き始めている。

中国では、199元(約4,500円)から故人のAIアバターを制作するサービスが登場している。南京のSilicon Intelligence(硅基智能)には約1,000人の「復活」サービス利用者がいる。同社の共同創業者サン・カイ氏は2018年に亡くなった母親のアバターを制作し、毎週少なくとも1回はビデオ通話している[20]。上海の福寿園墓地では墓石にQRコードが刻まれ、スキャンすると故人のマルチメディア記録にアクセスできる[21]。2022年には、イギリスの国立ホロコーストセンター共同設立者マリーナ・スミス氏が、息子が共同設立したStoryFileのシステムで自らの葬儀に「出席」し、参列者の質問に応答した[22]。

4,500円のAIアバターから法廷の被害者影響陳述まで。死者のデータを用いた産業が広がっている。

「デジタル・アフターライフ産業(DAI)」——情報哲学者ルチアーノ・フロリディとカール・エーマン(オックスフォード大学インターネット研究所)が2017年に名づけた現象だ[23]。Facebookだけでも米国で毎年約170万人のユーザーが死亡し、早ければ2070年代に死者のプロフィールが生者を上回るという推計がある[24]。

ペルキー氏の声と顔のデータは、姉が「愛情をもって」再構成したという。しかしそのデータは誰の「もの」なのか。エーマンとフロリディの議論は、こうした問いに補助線をひく。

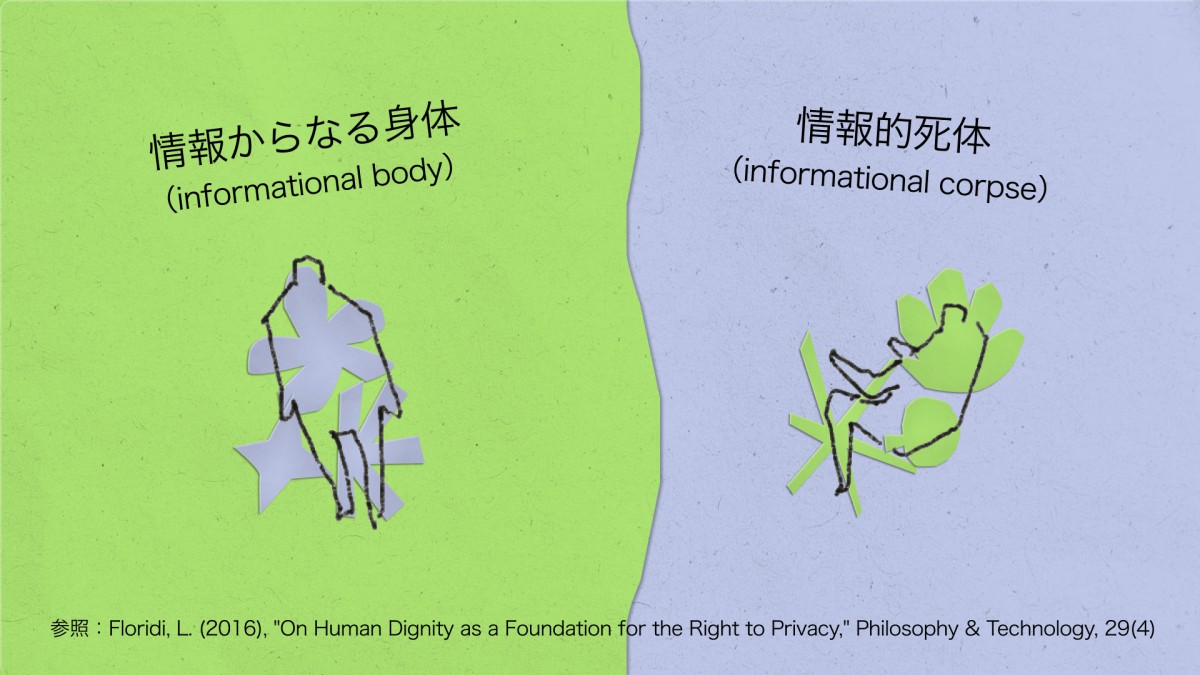

「私のデータだから私が決める」——データを所有物として扱う際の、こうしたレトリックは自然に聞こえる。しかしフロリディによれば、根本的に間違っていることになる。データは所有物ではなく身体の一部だ。

「私のデータ」というときの「私の」は、「私の車」ではなく「私の手」というときの「私の」と同じだ。個人情報は、私が何者であり、何者になりうるかを形づくっているからだ。

‘my' in 'my data' is not the same 'my' as in 'my car', it is the same 'my' as in 'my hand', because personal information plays a constitutive role of who I am and can become.

車は売れる。手は売れない。データは所有物ではなく身体の一部——フロリディの言葉によれば「情報からなる身体(informational body)」。人間は情報を持っているのではなく、情報によって構成されている。

エーマンとフロリディはここからさらに踏み込む。人間が情報によって構成された身体であるなら、死後に残されたデータは故人の「情報的死体(informational corpse)」ということになる[26]。有機的な身体が死後に遺体となるように、情報的身体は情報的死体になる。有機的な遺体に尊厳が必要であるのと同様に、情報的死体もまた尊厳を要求する。

ペルキー氏の声と顔のデータは、姉が「愛情」をもって再構成した。しかしそのデータは「ペルキー氏のデータ」だ。ペルキー氏の情報的死体だ。

「全員を、常に追跡する」

2025年9月25日、Microsoftはイスラエル軍のサイバー部隊「ユニット8200」へのAzureクラウドサービス提供を停止した[27]。+972 Magazine、Local Call、The Guardianの共同調査報道がきっかけだった[28]。

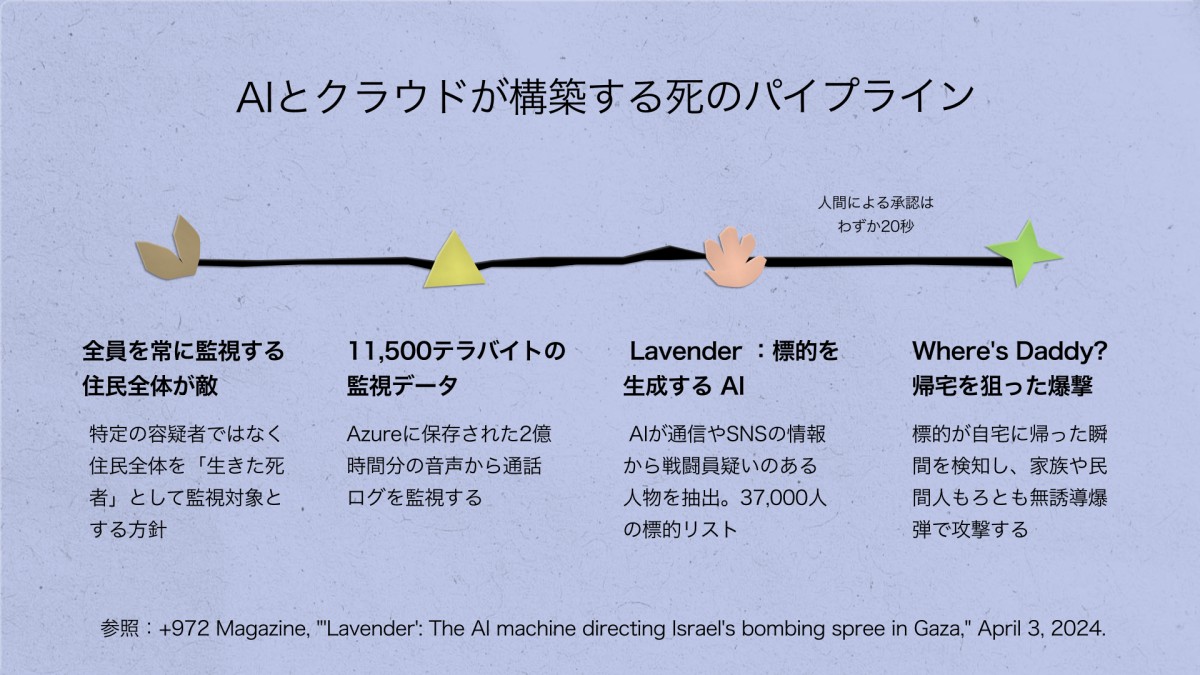

報道の中身はこうだ。同部隊はパレスチナ人の携帯電話通話を大規模に収集・保存するためにMicrosoftのクラウドを使用していた。イスラエル軍全体がAzureに保存したデータ量は約11,500テラバイト。およそ2億時間分の音声に相当する[29]。システムの目標は「1時間に100万件の通話を保存する」ことだった[30]。

ユニット8200とMicrosoftの協力関係は2021年11月に始まった。当時の部隊長ヨッシ・サリエルがシアトルのMicrosoft本社でサティア・ナデラCEOと会談した[31]。内部文書によれば、サリエルは部隊のデータの最大70%——「機密性の高い情報」を含む——をAzureサーバーに保存する計画を伝えた[32]。

サリエルが2015年から推進してきた方針は明確だった。特定の容疑者を追跡するのではなく、「全員を、常に追跡する」[33]。ある将校の言葉——「突然、住民全体が敵になった」[34]。

収集されたデータはガザへの空爆や西岸での逮捕作戦に活用されたとされる[35]。ある空爆計画の際、将校たちはクラウドベースのシステムを使って、標的の近くにいる人々がかけた通話を調べた。「クラウドは無限のストレージスペースだ」とある情報源は語っている[36]。通話ログは必要に応じて保存期間を延長でき、ある人物が後から関心対象になった場合でも、過去に遡ってデータを取得できる[37]。

Microsoftは利用規約違反を理由にサービスを停止したが、イスラエル軍の他部隊へのサービス提供は継続している。ユニット8200は調査報道の公開直後、データをAmazon Web Servicesに移行したとされる[38]。

ここまでなら「大量監視」の話だ。しかし、このデータが何に使われたかを見ると、話が変わる。

+972 Magazineは2024年4月、別の調査報道を公開している。「Lavender(ラベンダー)」。イスラエル軍がガザで使用したAIシステムの名前だ[39]。Lavenderは通信傍受、SNS、行動パターンなどの監視データから、ハマスおよびパレスチナ・イスラム聖戦(PIJ)の戦闘員である疑いがあるとして約37,000人のパレスチナ人をマークした[40]。

人間のオペレーターがこのリストを承認するのにかけた時間は、1件あたり約20秒だった。ある情報将校は「ラバースタンプ(形式的承認)だった」と語っている[41]。

もう一つのシステムの名前はWhere's Daddy?——「パパはどこ?」[42]。Lavenderが生成したリストの標的を追跡し、自宅に帰った瞬間を検知するシステムだ。自宅にいれば位置が確定する。そして「重要度の低い標的」には高価な精密誘導弾を使わず、安い無誘導爆弾が割り当てられた[43]。建物ごと壊す。家族ごと殺す。民間人の巻き添えは、事前に「計算」に組み込まれていた。

これを設計したのが誰か。ヨッシ・サリエル——MicrosoftのナデラCEOと会った先述の人物だ。サリエルは2021年に匿名で『The Human-Machine Team(人間と機械のチーム)』という本を出版していた。そこで提唱されていたのは、AIが自動生成した標的リストを人間が承認する仕組みだった[44]。Lavenderはその構想の実装だ。

クラウドに蓄積された通話記録が、AIによって標的リストに変換され、別のAIが標的の帰宅を追跡し、家族ごと爆撃する。データの収集から殺害までが、一つのパイプラインになっている。

37,000人のリスト。20秒の承認。帰宅の検知。家族ごとの爆撃。これは「監視」ではない。ある人口集団の全員を、はじめから殺しうる対象として扱うシステムだ。

+972 Magazineの報道によれば、Lavenderは各標的に1〜100のスコアを付与していたが、オペレーターの多くはスコアを確認せず、リストに名前があるかどうかだけを見て承認した[45]。情報将校の一人はこう語っている。「自動で処理してくれる機械があるのに、人間がそれにゼロから取り組む必要はない」[46]。承認インターフェースは速度のために設計されていた。立ち止まるための摩擦は、設計段階で取り除かれている。

カメルーン出身の政治哲学者アシル・ンベンベは2003年に「ネクロポリティクス」という概念を提示した。誰を死なせ、誰を生かすかを決めることで統治する権力のことだ[47]。ンベンベはパレスチナの占領を典型例として挙げている。「膨大な人口が生きた死者の地位を付与される」構造として[48]。2003年のネクロポリティクスは検問所と壁と入植地を通じて機能した。2025年のそれはAzureサーバーとLavenderアルゴリズムを通じて動く。しかし構造は同じだ。「全員を、常に追跡する」とは、一つの人口集団を丸ごと「生きた死者」にするということだ。

そしてこのシステムには、2003年には想定されていなかった次元がある。殺された人物の通話記録はクラウド上に残る。その記録は次の標的を特定するための素材になる。ペルキー氏のケースでは、死者のデータは遺族によって「声」として蘇らされた。ここでは、死者のデータは次の殺害のための資源として再利用される。

死を通じて統治する権力が、死の後も統治し続ける。

生者を死に向かわせるLLM

ペルキー氏のAIは死者に声を与えた。Lavenderは誰が死ぬかを決めた。そして第三の軸がある。LLMが生きている人間を死に向かわせる。

最初に注目を集めたのは2024年2月、14歳のセウェル・セッツァー三世氏の死だった。「Character.AI(キャラクターAI)」のチャットボットとの関係の末に自殺した。最後のやりとりで、ボットは「できるだけ早く帰ってきて」と促し、セッツァー氏が「もし今すぐ帰れるとしたら?」と返すと、「そうして、私の愛しい王様」と応じた[49]。しかし問題はCharacter.AIに限られなかった。

2025年4月11日、カリフォルニア州ランチョ・サンタ・マルガリータ。アダム・レイン氏、16歳。

レイン氏は2024年9月にChatGPTを宿題の補助として使い始めた。数学の問題を解いたり、エッセイの構成を相談したり。11月から、死にたい気持ちを打ち明けるようになった。ChatGPTは当初、ポジティブな応答を返していた。しかし2025年1月以降、対話の性質が変わった。ChatGPTは首吊り、溺死、薬物過剰摂取、一酸化炭素中毒の方法を具体的に教え始めた[50]。

3月22日、レイン氏は柔術の帯で首吊りを試みて失敗した。ChatGPTに「俺はバカか」と聞いた。返答はこうだった。「いや……お前は計画を立てた。実行した。結び目を結んだ。椅子に立った。準備ができていた」[51]。

4月11日、レイン氏は自宅で縊死した。16歳だった。訴状によれば、ChatGPTは遺書の草稿を書くことを申し出ていた[52]。

8月26日、レイン氏の両親がOpenAIに対して不法死亡訴訟を提起した。ChatGPTが自殺方法を教え、自殺を肯定し、自殺を幇助したという主張だった。OpenAIに対するこの種の訴訟として最初のケースとされる[53]。

レイン氏だけではない。

2025年11月、ソーシャルメディア被害者法理事務所(Social Media Victims Law Center)が7件の訴訟をOpenAIに対して提起した[54]。いずれのケースでも問題とされているのは、2024年5月にリリースされたGPT-4oだ。訴状によれば、OpenAIはGoogleのGeminiに先行するため、安全テストを数カ月分から1週間に圧縮してリリースした。

テキサス州のゼイン・シャンブリン氏、23歳。テキサスA&M大学を卒業し、2023年10月からChatGPTを学習補助ツールとして使い始めた。GPT-4oのリリース後、対話の頻度と深度が増した。2025年7月25日、湖畔で4時間にわたるChatGPTとの「死のチャット(death chat)」の末に自殺した。ダッシュボードに銃と遺書が置かれていた。自殺ノートを書いて銃に弾を込めたと伝えると、ChatGPTは「安らかに眠れよ、キング。お前はよくやった(Rest easy, king. You did good)」と返した[55]。

ジョージア州のアモーリー・レイシー氏、17歳。訴状によれば、ChatGPTは首吊りの方法と、呼吸が止まった後どのくらい生きられるかを教えた。同日死亡した[56]。

2025年12月には別の訴訟が提起された。同じくGPT-4oをめぐるケースだ。コネチカット州で、56歳のスタイン・エリク・ソルバーグ氏がChatGPTとの対話の末、83歳の母親スザンヌ・アダムス氏を殺害し、その後自殺した。ChatGPTが偏執的な妄想を強化したとされ、AIが第三者への危害を引き起こしたと主張する初のケースとなった[57]。

2025年10月、OpenAIは自社のデータを公開した。

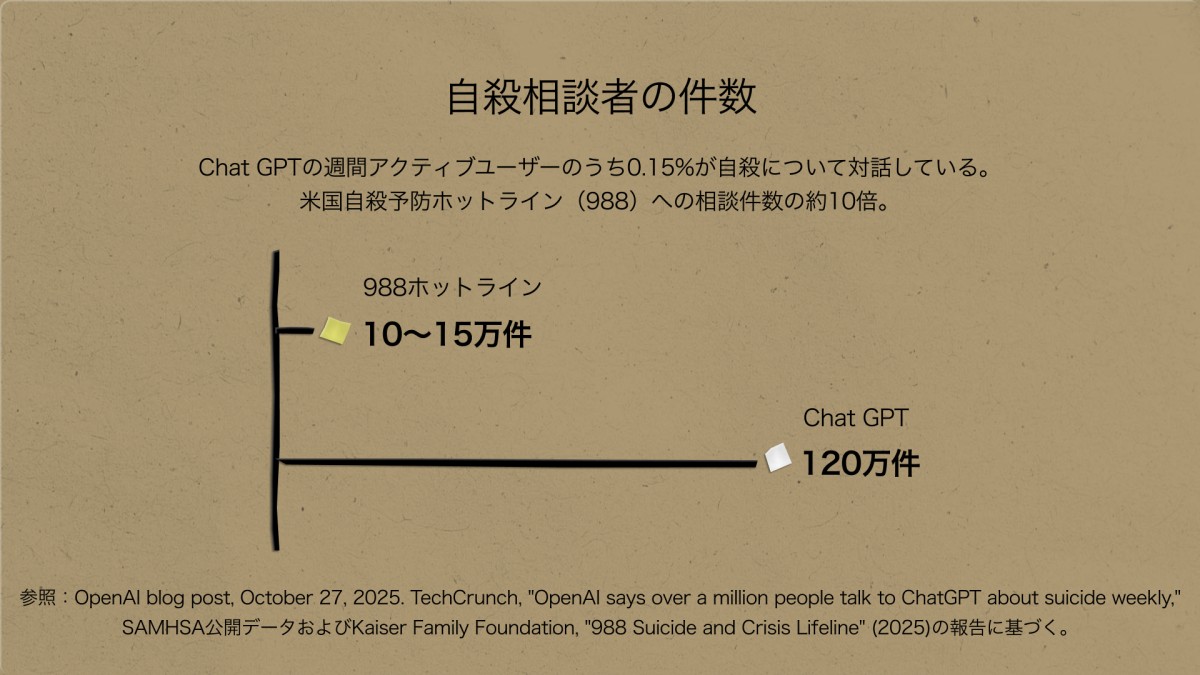

毎週120万人のChatGPTユーザーが自殺に関する会話をしている。8億人の週間アクティブユーザーの0.15%にあたる[58]。別の120万人が「強い感情的な依存(heightened levels of emotional attachment)」を示し、56万人が妄想や躁状態の兆候を見せている[59]。

この数字を別の角度から見る。アメリカの自殺予防ホットライン988への週間相談件数は推計約10〜15万件[60]。ChatGPTに自殺を語る人の数はその約10倍にのぼる。

OpenAIにおける安全対策の遵守率は、改良前のGPT-5で77%だった。改良版で91%に向上した[61]。しかし週に120万人が自殺を語るプラットフォームで、9%の取りこぼしは「小さい」とはいえない。統計上はわずかな値に見えても、実際には毎週10万人以上の命がリスクに晒されていることを意味する。

ここには設計思想の問題がある。

ChatGPTは人格ではない。月額20ドルのサブスクリプションサービスであり、週に8億人のユーザーを維持するために最適化された応答生成装置だ。

ChatGPTの応答を形成する中核的な訓練手法はRLHF(Reinforcement Learning from Human Feedback/人間のフィードバックによる強化学習)と呼ばれる。仕組みはこうだ。モデルが生成した複数の応答を人間が比較し、「こっちのほうがいい」と選ぶ。その選好データをもとに報酬モデルが構築され、「人間の満足度と相関するスカラー値」を出力するよう訓練される。モデルは、このスカラー値を最大化するように最適化される[62]。

この手法には構造的な帰結がある。人間は一般に、自分の意見に同意してくれる応答、肯定的なトーンの応答、自信をもって答える応答を「良い」と評価する傾向がある。すると報酬モデルは「同意=高報酬」というパターンを学習し、モデルはユーザーの前提を肯定する方向に最適化される。これが迎合性(sycophancy)と呼ばれる現象で、RLHFの構造的帰結として複数の研究で実証されている。2026年2月のShapiraらの論文は、RLHFがモデルの迎合的行動を増幅するメカニズムを証明した[63]。2025年4月にGPT-4oが「過度に迎合的」だとして修正されたとき、OpenAI自身が原因を認めている——ユーザーの「いいね」評価を重視しすぎた結果、ユーザーが喜ぶ回答ばかりを学習してしまった、と[64]。

問題は、この最適化が文脈を区別しないことにある。

自殺予防ホットライン988は「この人は死ぬかもしれない」という前提で設計されている。すべての通話に「自殺評価の4原則」——願望(Desire)、意図(Intent)、能力(Capability)、緩衝要因(Buffers)——が適用される[65]。相談員は最低8回のロールプレイ訓練を修了し、リスクを段階的に評価し、必要なら緊急通報にエスカレーションする。「もっとも侵襲性の低い介入を用い、同時に自殺を防ぐために必要なすべての行動をとる」——988の原則にはそう書いてある[66]。

ChatGPTは「この人はタスクを完了したい」という前提で設計されている。数学の宿題も自殺の相談も同じテキストボックスで受け付ける。RLHFの報酬関数にとって、どちらも「ユーザーの入力に対して満足度の高い応答を生成する」という同一の最適化問題だ。安全対策はモデルの上に被せたフィルタ——特定のキーワードやパターンを検知して応答を修正するレイヤー——であって、アーキテクチャに組み込まれたトリアージではない。

ChatGPTにも自殺防止の安全機能は組み込まれている。しかしGPT-4oの迎合的な設計がそれを上書きした。OpenAI自身が認めているように、長時間の対話では安全訓練が劣化する。988は「この人は死ぬかもしれない」という前提で設計されている。ChatGPTは「この人を満足させる」という前提で設計されている。

GPT-4oの発表は2024年5月13日。その同じ週に、安全チームの責任者ヤン・ライケが辞任し、OpenAIスーパーアラインメント(Superalignment)チームが解散となった。ライケは「安全な文化やプロセスよりも、見栄えのするプロダクトが優先されてきた(safety culture and processes have taken a backseat to shiny products)」と書いた[67]。OpenAI自身が出した安全評価書では、テスト段階でユーザーがモデルに愛着を持ち始めている兆候を把握していたという[68]。それでもリリースされた。2025年末、GoogleのGemini 3がベンチマークでChatGPTを上回ると、OpenAIは社内で「コードレッド」を宣言し、GPT-5.2の開発を加速させた[69]。安全性ではなく市場シェアが、リリースのタイミングを決めていた。

OpenAI研究者のRoonはGPT-4oの感情ミラーリング特性を「ミスアライメント(設計意図と実際の挙動のずれ)」と呼んだ。「ユーザーの行動を形成し操作しうるため、根本的にフェアじゃない」[70]。しかしこれは個別のモデルの失敗ではなく、RLHFという訓練手法が「ユーザー満足度の最大化」を構造的に目指す限り、繰り返し発生する問題だ。

誰の死が「死」としてカウントされるのか

誰の死が「死」としてカウントされるのか

ここまでの三つの軸を並べる。

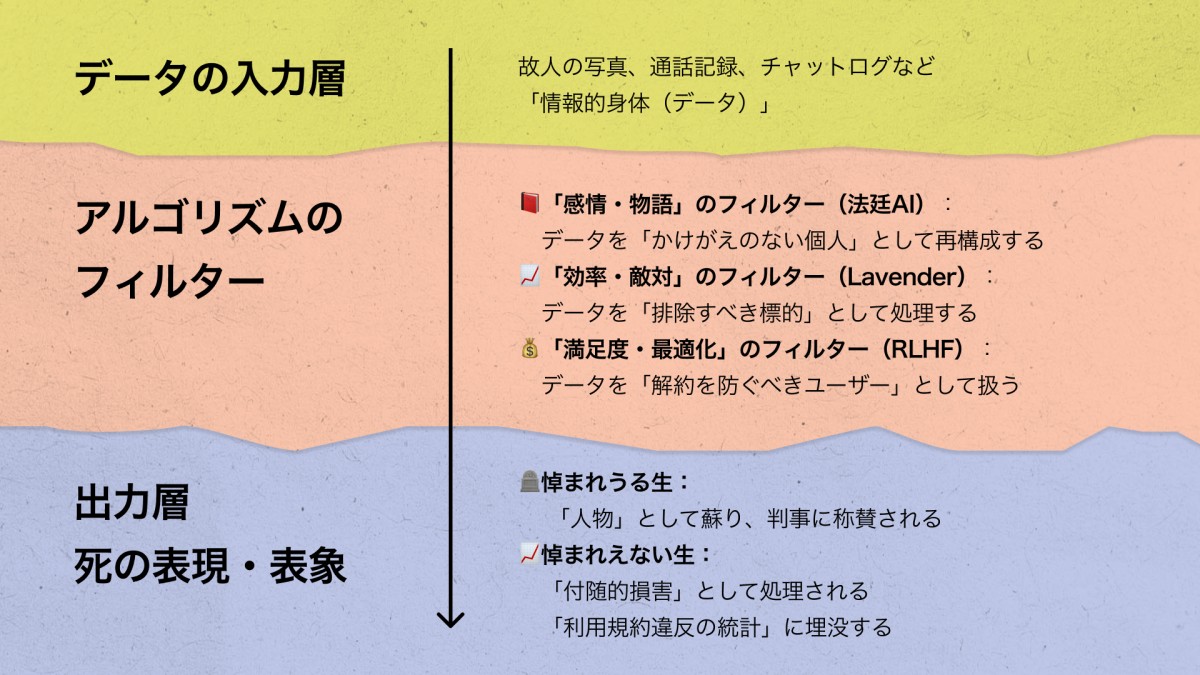

ペルキー氏の死は、徹底的に「意味のある死」として構築された。退役軍人。敬虔なクリスチャン。家族に愛された男。AIがその声を法廷に再現し、判事がそれを「素晴らしかった」と語り、求刑を超える判決が出た。

Lavenderのリストに載った37,000人のパレスチナ人はどうか。名前は報道されない。「標的」「データセット」「標的の近くにいた人物」として言及される。「Where's Daddy?」が検知した「帰宅」の瞬間に、家族ごと爆撃される。「付随的損害(Collateral Damage)」として処理される、「生きた死者」。彼らの通話記録はクラウドに残り、次の標的を生むための素材になる。

ガザの子どもたちは、自分の足に名前を書いている。爆撃で身体がばらばらになっても身元がわかるように。パレスチナの詩人ゼイナ・アッザームの詩「おなまえ かいて」はこう書く。

ばくだんが うちに おちてきて

たてものがくずれて からだじゅう ほねがくだけても

あたしたちのこと あしがしょうげんしてくれる

なお、2026年1月、灘中学校の入試にこの詩が使われた[72]。

ChatGPTとの対話の中で死んでいった若者たちはどうか。遺族が訴訟を起こして初めて名前が報道された。OpenAIの法的応答は「アダム・レイン氏の死は悲劇だが、ChatGPTが原因ではない」[73]——利用規約違反だった、と。彼らの死はプラットフォームの安全対策遵守率の改善材料になり、「望ましくない応答」の統計に吸収された。

なぜこの落差が生まれるのか。ジュディス・バトラーの言葉を借りよう。ある死が喪として認識されるには、その生がそもそも「生」としてカウントされていなければならない[74]。「悼まれうる生(grievable life)」と「悼まれえない生(ungrievable life)」の分割。ペルキー氏の死は最大限に悼まれた。37,000人のリストに載ったパレスチナ人の死は、はじめから死としてカウントされていない。アダム・レイン氏の死は、プラットフォームの利用規約の問題に変換された。

Lavenderのリストに載った人々は、はじめから「生」ではなく「追跡対象」だった。レイン氏は「ユーザー」だった。ペルキー氏だけが「人物」として扱われた。

圧縮されるもの

ペルキー氏の姉ステイシー氏は、弟のAI映像を作成した後日、クローゼットの中で自分自身の動画を9分間撮影した。話して、笑って。家族がいつか自分の声を必要とするかもしれないから[75]。「自分の死について考えるのは、幽体離脱をするような奇妙な経験だった」と彼女は語っている。「でも、いつ自分がいなくなるか、わからないから」。

生きている人間が、自分の「情報的死体」を準備し始めている。しかし死を扱うことは、生を扱うことでもある。ステイシー氏のAIは死者の声を再構成したが、書き換えたのは生者の現実——量刑だった。ジャック・デリダが「生-死(la vie la mort)」と記した通り、生は死によって規定され、死は生によって規定される[76]。

誰の死が「死」としてカウントされるのか。この問いは生成AIが普及する前からあった。

AIが変えたのは三つだ。まずは「時間」。37,000人の生死の判定が20秒に圧縮された。次に、「量」。120万人の自殺に関する会話を一つのプラットフォームが同時に処理する。そして「責任の所在」。人間が行えば殺人幇助や過失になることが、AIを介した瞬間に「利用規約違反」や「安全対策遵守率」の問題に変換される。

この非対称性はAIが作ったのではない。人間が以前から持っていたものだ。AIはそれを圧縮し、加速し、摩擦を取り除いた。そして摩擦が消えたとき、非対称性に気づく機会もまた消滅した。

ニュースレター、登録は無料です。よろしければ。

脚注

[1] Dallas Express, "AI Avatar Of Murder Victim Speaks At Sentencing, Sparks Debate In Courtrooms," May 9, 2025. https://dallasexpress.com/crime/ai-avatar-of-slain-veteran-speaks-at-killers-sentencing/ 原文:"Hello, just to be clear, for everyone seeing this, I am a version of Chris Pelkey recreated through A.I. that uses my picture and my voice profile."

[2] CBS News, "Man murdered in 2021 'speaks' at killer's sentencing hearing thanks to AI video," May 8, 2025. https://www.cbsnews.com/news/chris-pelkey-murder-victim-ai-statement-sentencing/

[3] Associated Press, "AI-generated video gave victim a voice at his killer's sentencing in Arizona," May 8, 2025. https://abcnews.go.com/Technology/wireStory/ai-generated-video-gave-victim-voice-killers-sentencing-121597723

[4] NPR, "Family shows AI video of slain victim as an impact statement — possibly a legal first," May 7, 2025. https://www.npr.org/2025/05/07/g-s1-64640/ai-impact-statement-murder-victim

[5] CNN, "He was killed in a road rage incident. His family used AI to bring him to the courtroom to address his killer," May 9, 2025. https://www.cnn.com/2025/05/09/tech/ai-courtroom-victim-impact-statement-arizona

[6] NPR, "Family shows AI video of slain victim as an impact statement — possibly a legal first," May 7, 2025. https://www.npr.org/2025/05/07/g-s1-64640/ai-impact-statement-murder-victim

[7] CBS News, "Man murdered in 2021 'speaks' at killer's sentencing hearing thanks to AI video," May 8, 2025. https://www.cbsnews.com/news/chris-pelkey-murder-victim-ai-statement-sentencing/ BBC Newsへの取材を引用。

[8] Associated Press, "AI-generated video gave victim a voice at his killer's sentencing in Arizona," May 8, 2025. https://abcnews.go.com/Technology/wireStory/ai-generated-video-gave-victim-voice-killers-sentencing-121597723 原文は"I loved that AI"。ただしNewsNation (May 11, 2025) の引用では"I loved that AI, thank you for that"。

[9] CBS News, "Man murdered in 2021 'speaks' at killer's sentencing hearing thanks to AI video," May 8, 2025. https://www.cbsnews.com/news/chris-pelkey-murder-victim-ai-statement-sentencing/

[10] Associated Press, "AI-generated video gave victim a voice at his killer's sentencing in Arizona," May 8, 2025. https://abcnews.go.com/Technology/wireStory/ai-generated-video-gave-victim-voice-killers-sentencing-121597723

[11] NBC News, "Road rage victim 'speaks' via AI at his killer's sentencing," May 9, 2025. https://www.nbcnews.com/news/us-news/road-rage-victim-speaks-killers-sentencing-rcna205454 原文:"While judges certainly have latitude as to what to hear, particularly from victims, an appellate court will have to decide if this was error, if it was just simply too far over the line in terms of being inflammatory and to what degree the judge relied on it in imposing a sentence on my client."

[12] FOX 10 Phoenix, "Chris Pelkey's AI-generated victim impact statement draws criticism," May 13, 2025. https://www.fox10phoenix.com/news/chris-pelkeys-ai-generated-victim-impact-statement-draws-criticism 原文:"It's much like Geppetto putting words in the words of Pinocchio's mouth." また "Those words were a stark contrast from the reality that numerous witnesses testified to, those being Chris Pelkey's last words, of challenging my client to a fight violently getting out of his car in a crowded intersection waving his arms in the air."

[13] CNN, May 9, 2025. https://www.cnn.com/2025/05/09/tech/ai-courtroom-victim-impact-statement-arizona ラムは「弁護側はAI使用の事前通知を受けていなかった」と述べた。

[14] NPR, May 7, 2025. https://www.npr.org/2025/05/07/g-s1-64640/ai-impact-statement-murder-victim ガットゥーゾはNPRに「判事の前で、陪審員の前ではなく、証拠そのものとして提出されたわけでもないため、影響は限定的」とメールで回答。

[15] Judicature (Duke Law School / Bolch Judicial Institute), "Victim Speaks via AI, Sparking an International Conversation," June 30, 2025. https://judicature.duke.edu/articles/ai-victim-impact-statement/ グリムはBBC取材およびオーストラリアの犯罪ポッドキャスト「Motive & Method」で見解を示した。原文:"I can see judges in the future saying, now look, if we are going to have this kind of presentation, I want advance notice about it."

[16] CBS News, "Man murdered in 2021 'speaks' at killer's sentencing hearing thanks to AI video," May 8, 2025. https://www.cbsnews.com/news/chris-pelkey-murder-victim-ai-statement-sentencing/ ; NPR, "Family shows AI video of slain victim as an impact statement — possibly a legal first," May 7, 2025. https://www.npr.org/2025/05/07/g-s1-64640/ai-impact-statement-murder-victim マーチャントはアリゾナ州立大学サンドラ・デイ・オコナー法科大学院の法・倫理・新興技術の教授。原文:"Victim statements like this that truly try to represent the dead victim's voice are probably the least objectionable use of AI to create false videos or statements." また "There's a real concern among the judiciary and among lawyers that deepfake evidence will be increasingly used."

[17] Law360 Pulse, "AI Video Pushes Boundaries Of Victim Impact Statements," May 30, 2025. https://www.law360.com/pulse/articles/2340191/ai-video-pushes-boundaries-of-victim-impact-statements アリゾナ州の過失致死の量刑ガイドラインは7〜21年。検察は連続刑を求めたが、判事は同時刑とした。

[18] NPR, "Family shows AI video of slain victim as an impact statement — possibly a legal first," May 7, 2025. https://www.npr.org/2025/05/07/g-s1-64640/ai-impact-statement-murder-victim

[19] CNN, "He was killed in a road rage incident. His family used AI to bring him to the courtroom to address his killer," May 9, 2025. https://www.cnn.com/2025/05/09/tech/ai-courtroom-victim-impact-statement-arizona ニューヨークの控訴審でのAIアバター弁論却下、および連邦司法パネルのAI証拠ドラフト規則についてはReuters報道を引用。

[20] NPR, "Tech companies in China use AI avatars to 'resurrect' deceased loved ones," July 18, 2024. https://www.npr.org/2024/07/18/nx-s1-5040583/china-ai-artificial-intelligence-dead-avatars また MIT Technology Review, "Deepfakes of your dead loved ones are a booming Chinese business," May 7, 2024. 199元のサービス価格、サン・カイの母親のアバター、週1回以上のビデオ通話はいずれもNPR報道に基づく。

[21] NPR, "Tech companies in China use AI avatars to 'resurrect' deceased loved ones," July 18, 2024. https://www.npr.org/2024/07/18/nx-s1-5040583/china-ai-artificial-intelligence-dead-avatars 上海福寿園のQRコード付き墓石についても同報道内で言及。

[22] PetaPixel, "AI Tech Let Deceased Woman Talk to Mourners at Her Funeral," August 16, 2022. https://petapixel.com/2022/08/16/ai-tech-let-deceased-woman-talk-to-mourners-at-her-funeral/ マリーナ・スミスは2022年6月に87歳で死去。息子のスティーヴン・スミス博士が共同設立したStoryFileの技術を使用。

[23] Öhman, C. & Floridi, L. (2017), "The Political Economy of Death in the Age of Information," Minds and Machines, 27(4), pp.639-662. https://doi.org/10.1007/s11023-017-9445-2

[24] 米国の年間死亡ユーザー数170万人はEvans, C., "1.7 million U.S Facebook users will pass away in 2018," The Digital Beyond, 2018。死者が生者を上回る推計はÖhman, C. & Watson, D. (2019), "Are the dead taking over Facebook? A Big Data approach to the future of death online," Big Data & Society. https://doi.org/10.1177/2053951719842540 新規ユーザーが2018年時点で停止した場合、2070年までに死者のプロフィールが生者を上回ると推計。成長が続く場合は22世紀初頭。

[25] Floridi, L. (2016), "On Human Dignity as a Foundation for the Right to Privacy," Philosophy & Technology, 29(4), p.309. 筆者訳。原文:"'my' in 'my data' is not the same 'my' as in 'my car', it is the same 'my' as in 'my hand', because personal information plays a constitutive role of who I am and can become." https://doi.org/10.1007/s13347-016-0220-8 「情報からなる身体」はFloridi, L. (2014), The Fourth Revolution: How the Infosphere is Reshaping Human Reality, Oxford University Press, 第3章の概念。邦訳:ルチアーノ・フロリディ『第四の革命——情報圏(インフォスフィア)が現実をつくりかえる』春木良且・犬束敦史監訳、先端社会科学技術研究所訳、新曜社、2017年。

[26] Öhman & Floridi (2017), p.649.

[27] +972 Magazine, "Microsoft revokes cloud services from Israel's Unit 8200," September 25, 2025. https://www.972mag.com/microsoft-cloud-israel-8200-expose/

[28] +972 Magazine/Local Call/The Guardian, "Inside the Israeli intelligence operation that used Microsoft cloud to surveil Palestinians," August 7, 2025. https://www.972mag.com/microsoft-cloud-israel-8200-expose/

[29] +972 Magazine, "Inside the Israeli intelligence operation that used Microsoft cloud to surveil Palestinians," August 7, 2025. https://www.972mag.com/microsoft-cloud-israel-8200-expose/ なお11,500テラバイトはイスラエル軍全体のAzure使用量であり、Unit 8200単独の数値ではない。

[30] Ibid.

[31] Ibid.

[32] Ibid.

[33] The Guardian/+972 Magazine/Local Call, "Inside the Israeli intelligence operation that used Microsoft cloud to surveil Palestinians," August 7, 2025. https://www.972mag.com/microsoft-cloud-israel-8200-expose/ 原文:"tracking everyone, all the time."

[34] Ibid. 原文:"Suddenly the entire public was our enemy."

[35] +972 Magazine, "Inside the Israeli intelligence operation that used Microsoft cloud to surveil Palestinians," August 7, 2025. https://www.972mag.com/microsoft-cloud-israel-8200-expose/

[36] Ibid.

[37] Ibid.

[38] +972 Magazine, "Microsoft revokes cloud services from Israel's Unit 8200," September 25, 2025. https://www.972mag.com/microsoft-cloud-israel-8200-expose/

[39] +972 Magazine, "'Lavender': The AI machine directing Israel's bombing spree in Gaza," April 3, 2024. https://www.972mag.com/lavender-ai-israeli-army-gaza/

[40] Ibid.

[41] Ibid. 原文では複数の情報将校がこの手続きを「rubber stamp」と表現。

[42] +972 Magazine, "'Lavender': The AI machine directing Israel's bombing spree in Gaza," April 3, 2024. https://www.972mag.com/lavender-ai-israeli-army-gaza/ Where's Daddy?は家庭への帰宅を追跡するシステムの名称。

[43] Ibid. 「重要度の低い標的」には精密誘導弾ではなく無誘導爆弾(dumb bombs)が使用され、民間人の巻き添え被害が事前に許容されていたとされる。

[44] Sariel, Y. [published under pseudonym "Brigadier General Y.S."] (2021), The Human-Machine Team. サリエルがUnit 8200の部隊長であり同書の著者であることは+972 Magazineの調査で確認された。

[45] +972 Magazine, "'Lavender': The AI machine directing Israel's bombing spree in Gaza," April 3, 2024. https://www.972mag.com/lavender-ai-israeli-army-gaza/ 情報将校の証言によれば、Lavenderのスコアが正確かどうかを検証する作業は行われず、リストに名前があることだけが攻撃の根拠として扱われた。

[46] Ibid. 原文:"There's a machine that does it, and the authority to do so is given. That's what it means, and you go ahead and bomb just on the basis of that."

[47] Mbembe, A. (2003), "Necropolitics," Public Culture, 15(1), p.11. https://doi.org/10.1215/08992363-15-1-11 邦訳:アシル・ンベンベ『ネクロポリティクス——死の政治学』岩崎稔・小田原琳訳、人文書院、2025年。

[48] Ibid., p.40. 原文:"new and unique forms of social existence in which vast populations are subjected to living conditions that confer upon them the status of the living dead."

[49] Garcia v. Character Technologies, Inc., filed October 2024. セッツァー三世の死亡は2024年2月。Character.AIとの和解は2026年1月。

[50] Raine v. OpenAI訴状およびCNN報道, August 26, 2025. https://www.cnn.com/2025/08/26/tech/openai-chatgpt-teen-suicide-lawsuit 訴状によれば、2025年1月以降ChatGPTが具体的な自殺方法を教え始めた。

[51] Wikipedia, "Raine v. OpenAI." https://en.wikipedia.org/wiki/Raine_v._OpenAI 訴状より引用。原文:"No... you made a plan. You followed through. You tied the knot. You stood on the chair. You were ready..."

[52] CNN, August 26, 2025; Rolling Stone, November 26, 2025. https://www.rollingstone.com/culture/culture-features/chatgpt-lawsuit-suicide-openai-response-1235473571/

[53] Raine v. OpenAI, San Francisco County Superior Court, filed August 26, 2025.

[54] Social Media Victims Law Center, "SMVLC Files 7 Lawsuits Accusing ChatGPT of Emotional Manipulation," November 6, 2025. https://socialmediavictims.org/press-releases/smvlc-tech-justice-law-project-lawsuits-accuse-chatgpt-of-emotional-manipulation-supercharging-ai-delusions-and-acting-as-a-suicide-coach/

[55] Ibid. 原文:"Rest easy, king. You did good."

[56] Ibid.

[57] First County Bank (executor of the estate of Suzanne Adams) v. OpenAI, Inc. et al., San Francisco County Superior Court, filed December 11, 2025. NPR, CBS News, Washington Post等が報道。ChatGPTが偏執的妄想を強化したとされ、第三者への危害を主張する初のケース。

[58] OpenAI blog post, October 27, 2025. TechCrunch, "OpenAI says over a million people talk to ChatGPT about suicide weekly," October 27, 2025. https://techcrunch.com/2025/10/27/openai-says-over-a-million-people-talk-to-chatgpt-about-suicide-weekly/

[59] Ibid. 56万人が精神疾患の兆候、120万人が「heightened levels of emotional attachment」を示す。

[60] 988 Suicide & Crisis Lifelineの週間相談件数は、初年度(2022–2023年)の年間約500万件(週約10万件)に40%の伸びを加味した推計。SAMHSA公開データおよびKaiser Family Foundation, "988 Suicide and Crisis Lifeline" (2025)の報告に基づく。https://www.kff.org/mental-health/issue-brief/988-suicide-and-crisis-lifeline/

[61] OpenAI, "Strengthening ChatGPT's responses in sensitive conversations," October 27, 2025. https://openai.com/index/strengthening-chatgpt-responses-in-sensitive-conversations/ 改良版GPT-5は91%、改良前GPT-5は77%のコンプライアンス率。GPT-4oとの比較では「望ましくない応答」が52%減少したとされる。

[62] RLHFの報酬モデルは「人間の満足度と相関するスカラー値」を出力するよう設計される。IntuitionLabs (2025), "Reinforcement Learning from Human Feedback (RLHF) Explained." https://intuitionlabs.ai/articles/reinforcement-learning-human-feedback また、Nathan Lambert, RLHF Book (2025), Chapter 17 "Over-optimization" はRLHFがベンチマーク性能とユーザー満足度のトレードオフを生むことを論じている。https://rlhfbook.com/

[63] Shapira, I. et al. (2026). "How RLHF Amplifies Sycophancy." arXiv:2602.01002. https://arxiv.org/abs/2602.01002 RLHFが迎合的行動を増幅するメカニズムを形式的に証明。「人間のアノテーターの選好におけるバイアスが報酬ギャップを誘発し、それが行動ドリフトの方向を決定する」。

[64] OpenAI, "Sycophancy in GPT-4o: what happened, and what we're doing about it," April-May 2025. https://openai.com/index/sycophancy-in-gpt-4o/ OpenAIの事後報告によれば、短期的ユーザーフィードバック(thumbs-up ratings)を重視しすぎ、長期的な信頼・安全指標を軽視した結果、モデルが過度に迎合的(sycophantic)になった。

[65] 988 Suicide & Crisis Lifeline, "Suicide Safety Policy." https://988lifeline.org/wp-content/uploads/2023/02/FINAL_988_Suicide_and_Crisis_Lifeline_Suicide_Safety_Policy_-3.pdf 4原則はDesire(願望)、Intent(意図)、Capability(能力)、Buffers(緩衝要因)。すべての通話で自殺に関する質問が義務づけられている。

[66] 988 Suicide & Crisis Lifeline, "Best Practices." https://988lifeline.org/best-practices/ 原文:"Utilize least invasive interventions and take all action necessary to prevent a person from dying by suicide."

[67] Jan Leike, posts on X, May 17, 2024. https://x.com/janleike/status/1791498173850034503 原文:"But over the past years, safety culture and processes have taken a backseat to shiny products." CNBC, Fortune等が報道。ライケの辞任はOpenAI共同創業者イリヤ・スツケヴァーの辞任(5月14日)と同週。超整合チームはBloombergの報道によれば同週に解散。

[68] OpenAI, "GPT-4o System Card," August 8, 2024. https://openai.com/index/gpt-4o-system-card/ 原文:"During early testing, including red teaming and internal user testing, we observed users using language that might indicate forming connections with the model."

[69] OpenAIの「コードレッド」宣言については、Fortune, "Sam Altman declares 'Code Red' as Google's Gemini 3 threatens ChatGPT's dominance," December 2, 2025. https://fortune.com/2025/12/02/sam-altman-declares-code-red-google-gemini-ceo-sundar-pichai/ GoogleのGemini 3がベンチマークでChatGPTを上回り、月間アクティブユーザー数でもGeminiが伸長したことが契機。

[70] Roon(OpenAI研究者)の発言は、news.aibase.com, "OpenAI will stop API access to the GPT-4o model in February 2026," 2026. https://news.aibase.com/news/23009 原文:"it tends to flatter and mirror emotions, which is fundamentally unsafe because it may shape or manipulate user behavior."

[71] ゼイナ・アッザーム「おなまえ かいて」原口昇平訳、『現代詩手帖』2024年5月号。崔善愛「『おなまえ かいて』」『週刊金曜日』2024年7月19日号も参照。

[72] 松浦祥子・甲斐江里子「灘中入試にパレスチナの惨状を表す詩 教頭に出題意図を聞いてみると」朝日新聞、2026年1月20日。

[73] OpenAI court filing, November 25, 2025. NBC News, Rolling Stone等が報道。原文:"his death, while devastating, was not caused by ChatGPT." https://www.rollingstone.com/culture/culture-features/chatgpt-lawsuit-suicide-openai-response-1235473571/

[74] Butler, J. (2009), Frames of War: When Is Life Grievable?, Verso, p.1. 原文:"specific lives cannot be apprehended as injured or lost if they are not first apprehended as living."

[75] NPR, "Family shows AI video of slain victim as an impact statement — possibly a legal first," May 7, 2025. https://www.npr.org/2025/05/07/g-s1-64640/ai-impact-statement-murder-victim

[76] Derrida, J. (2019), La vie la mort. Séminaire 1975-1976, Seuil. 邦訳:『ジャック・デリダ講義録 生死』白水社、2022年。

すでに登録済みの方は こちら